浅析汽车传感器融合系统

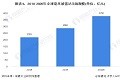

Autopilot 2.0 与 Autopilot 1.0 硬件对比情况

特斯拉的完全自动驾驶硬件系统包括:

1)车身四周加装 8 个摄像头,能够测量 250 米范围内的物体;

2)搭载 12 颗 超声波传感器,用以辅助侦测;

3)升级增强版的毫米波雷达,能够在恶劣天气下工作,也能探测到前方车辆;

4)汽车主板的性能是前款产品的 40 倍,大幅提升计算能力。

特斯拉本次发布Autopilot 2.0的完全自动驾驶硬件变化最大的在于摄像头,数量从原先的1个增至8个。 这也预示着特斯拉感知端的技术路线从原先的摄像头,到倚重雷达,最后又重新选择了摄像头。

特斯拉不断变化的主控传感器选择说明感知端目前还没有完全固定的技术路线,特斯拉自身也是在探索中不断地前进。

Mobileye

实际上,与特斯拉“分手”,是Mobileye提出来的。

经过十几年的研发创新,Mobileye凭借其EyeQ系列芯片上的高级视觉算法可实现多种ADAS功能,已成为视觉系ADAS产品中绝对的龙头。

从2007年研发出的第一代EyeQ产品开始,Mobileye与意法半导体合作,不断升级芯片技术,优化视觉算法,EyeQ3产品的运算速度已是第一代产品的48倍。

Mobileye 的 EyeQ 系列产品升级情况

从表格中我们可以看到,前三代产品都只搭载一颗摄像头。目前EyeQ4、EyeQ5产品计划已发布,其中EyeQ4将开始使用多摄像头方案。预计未来通过芯片升级和算法优化,Mobileye的芯片算法将融合更多传感器,将推出多目摄像头+毫米波雷达+激光雷达的解决方案,全面支持无人驾驶。

2016年7月,Mobileye 宣布和特斯拉终止合作,EyeQ3 将会是 Mobileye 和特斯拉的最后一次合作。几乎同时,Mobileye 还宣布英特尔、宝马进行合作。今年3月,英特尔以溢价33%+的价格收购Mobileye。

其实,Mobileye与特斯拉终止合作的深层次原因在于:

1)风格策略不同。Mobileye相对保守,特斯拉相对激进,因此Mobileye更倾向与传统汽车厂商合作。

2)数据归属有争议。Mobileye提出了一个名为REM的概念,数据将由加入的成员共享,而作为积累里程以及数据最多的特斯拉不愿意白白把数据共享给别的车厂。

不过特斯拉只是Mobileye所面对的众多整车客户之一,但是与英特尔的强强联合,Mobileye将受益于英特尔从芯片端提供的资源帮助,构造基于视觉、实现传感器融合的强大算法,推动视觉算法持续向自动驾驶迈进。

趋势——多传感器融合

对比特斯拉跟Mobileye的产品升级我们会发现,“老情人”的肉体虽然分离了,但精神上还是一致的。都是通过增加传感器的数量,并让多个传感器融合来提高自动驾驶能力。

上面提到的特斯拉事故中,主要原因有:

毫米波雷达测距可能误判。毫米波雷达测到前方有巨大障碍物,但可能因为卡车反射面积过大和车身过高,毫米波雷达将拖挂车误判为悬挂在道路上方的交通指示牌;

摄像头强光致盲

前置摄像头 EyeQ3 可能误判。事故拖挂车是横置的,全身白色,没有色彩警告,在阳光强烈的环境下,图像识别系统容易将拖挂车误判为白云。

在极端情况下,特斯拉的毫米波雷达和前置摄像头均发生了误判。可见摄像头+毫米波雷达方案缺乏冗余度,容错性差, 难以完成自动驾驶的使命,需要多个传感器信息融合综合判断。

传感器各有优劣,难以互相替代,未来要实现自动驾驶,是一定需要多种(个) 传感器相互配合共同构成汽车的感知系统的。不同传感器的原理、功能各不相同,在不同的使用场景里可以发挥各自优势,难以互相替代。

多个同类或不同类传感器分别获得不同局部和类别的信息,这些信息之间可能相互补充,也可能存在冗余和矛盾,而控制中心最终只能下达唯一正确的指令,这就要求控制中心必须对多个传感器所得到的信息进行融合,综合判断。

试想一下,如果一个传感器所得到的信息要求汽车立即刹车,而另一传感器显示可以继续安全行驶,或者一个传感器要求汽车左转,而另一个传感器要求汽车右转,在这种情况下,如果不对传感器信息进行融合,汽车就会“感到迷茫而不知所措”, 最终可能导致意外的发生。

因此在使用多种(个)传感器的情况下,要想保证安全性,就必须对传感器进行信息融合。 多传感器融合可显著提高系统的冗余度和容错性,从而保证决策的快速性和正确性,是自动驾驶的必然趋势。

多传感器融合要求:

1)硬件层面,数量要足够,也就是不同种类的传感器都要配备,才能够保证信息获取充分且有冗余;

2)软件层面,算法要足够优化,数据处理速度要够快,且容错性要好,才能保证最终决策的快速性和正确性。

算法是多传感器融合的核心

简单地说,传感器融合就是将多个传感器获取的数据、信息集中在一起综合分析以便更加准确可靠地描述外界环境,从而提高系统决策的正确性。

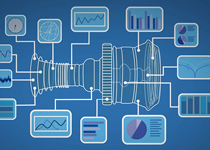

多传感器融合的基本原理

多传感器融合的基本原理类似于人类大脑对环境信息的综合处理过程。人类对外界环境的感知是通过将眼睛、耳朵、鼻子和四肢等感官(各种传感器)所探测的信息传输至大脑(信息融合中心),并与先验知识(数据库)进行综合,以便对其周围的环境和正在发生的事件做出快速准确地评估。

多传感器融合的体系结构:分布式、集中式和混合式。

1)分布式。先对各个独立传感器所获得的原始数据进行局部处理,然后再将结果送 入信息融合中心进行智能优化组合来获得最终的结果。分布式对通信带宽的需求低、 计算速度快、可靠性和延续性好,但跟踪的精度却远没有集中式高。

2)集中式。集中式将各传感器获得的原始数据直接送至中央处理器进行融合处理, 可以实现实时融合。其数据处理的精度高,算法灵活,缺点是对处理器的要求高,可 靠性较低,数据量大,故难于实现。

3)混合式。混合式多传感器信息融合框架中,部分传感器采用集中式融合方式,剩 余的传感器采用分布式融合方式。混合式融合框架具有较强的适应能力,兼顾了集中 式融合和分布式的优点,稳定性强。混合式融合方式的结构比前两种融合方式的结构 复杂,这样就加大了通信和计算上的代价。

三种传感器融合体系结构的对比

因为多传感器的使用会使需要处理的信息量大增,这其中甚至有相互矛盾的信息,如何保证系统快速地处理数据,过滤无用、错误信息,从而保证系统最终做出及时正确的决策十分关键。

目前多传感器融合的理论方法有贝叶斯准则法、卡尔曼滤波法、D-S 证据理论法、模糊集理论法、人工神经网络法等。

从我们上面的分析可看出,多传感器融合在硬件层面并不难实现,重点和难点都在算法上。多传感器融合软硬件难以分离,但算法是重点和难点,拥有很高的技术壁垒,因此算法将占据价值链的主要部分。

结语

在自动驾驶的浪潮下,自主品牌车企对智能化、电子化的需求比合资车企更加强劲,随之而来的便是自主一二级零部件供应商在该领域的机会,过去几年,零部件行业也在持续布局等待市场开启。

相对于控制层和执行层多被互联网巨头、整车厂及 Tier 1 所控制,传感器层的零部件供应商较为分散且门槛相对低一些,进入周期相对短一些。传感层仍然是国内企业进入自动驾驶产业最容易的切入点。

图片新闻

最新活动更多

-

3月27日立即报名>> 【工程师系列】汽车电子技术在线大会

-

7.30-8.1火热报名中>> 全数会2025(第六届)机器人及智能工厂展

-

7月30-31日报名参会>>> 全数会2025中国激光产业高质量发展峰会

-

免费参会立即报名>> 7月30日- 8月1日 2025全数会工业芯片与传感仪表展

-

精彩回顾立即查看>> 【在线会议】从直流到高频,材料电特性参数的全面表征与测量

-

精彩回顾立即查看>> 【在线会议】AI加速卡中村田元器件产品的技术创新探讨

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论